L’homme est de nature égocentrique. Trônant au sommet de la chaîne alimentaire, il est persuadé que l’univers a été créé pour lui. Ce n’est qu’au 16ème siècle avec Nicolas Copernic (a) qu’il a bien voulu admettre que la Terre n’est pas au centre de l’Univers. De nos jours nous savons qu’elle n’est qu’une modeste planète en orbite autour d’une étoile tout à fait ordinaire située sur le pourtour d’une galaxie comme beaucoup d’autres au sein d’un univers immense.

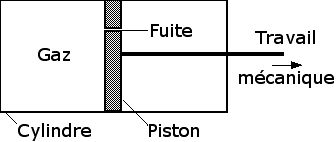

L’homme est très fier de son savoir faire. ll est le seul animal de la planète à créer des objets d’une grande complexité technique. Étant lui-même un objet encore plus complexe, il est persuadé qu’il n’a pu être créé que par un être encore supérieur qu’il appelle Dieu. Ce n’est qu’au 19ème siècle avec Charles Darwin (b) qu’il prend conscience de sa véritable origine. L’homme et le singe ont un ancêtre commun qui descend lui-même d’animaux antérieurs. L’homme n’est que le fruit tout récent de l’évolution (c) des espèces. Darwin n’est pas allé jusqu’à s’interroger sur l’origine même de la vie qu’il laissait à Dieu, mais il n’en était pas loin.

|

| Charles Darwin (photo Wikipédia) |

De nos jours nous savons que les êtres vivants obéissent aux mêmes lois physico-chimiques que la matière inerte. Au cours de ce blog nous avons vu qu’ils font partie de la catégorie des phénomènes dissipatifs dont font aussi partie des phénomènes infiniment plus simples comme les cellules convectives (article 10) ou les cyclones (article 11), généralement considérés comme non-vivants. Nous avons vu que la vie est apparue peu à peu sur Terre sous la forme d’une cascade de réactions chimiques cycliques imbriquées les unes dans les autres et catalysées indirectement par une molécule particulière appelée ADN.

Cette suite de réactions biochimiques de plus en plus complexes a pris naissance peu après la formation de la Terre. Il aura fallu près de 4,5 milliards d’années pour aboutir à l’homme. Le mérite de Darwin est d’avoir élucidé le mécanisme apparemment très simple de cette extraordinaire évolution, mécanisme dont j’ai essayé de montrer la mise en route progressive. Lorsqu’un être vivant se reproduit, un nouvel être se développe de lui-même presque identique au précédant. L’important est le mot “presque”. On observe toujours de petites variations dues au hasard. Darwin savait que si l’on sélectionne ceux qui présentent une variation intéressante et qu’on les fait se reproduire, cette même variation va se retrouver à la génération suivante. On peut ainsi de générations en générations sélectionner et multiplier le nombre d’individus possédant ce caractère particulier. C’est le principe de la sélection artificielle (d) pratiquée par les éleveurs et les agriculteurs.

L’idée de Darwin est qu’il existe aussi une sélection naturelle (e). Suivant l’environnement, une variation accidentelle peut être favorable ou défavorable. Si elle est favorable le nouvel être vivra plus longtemps et se reproduira davantage. En quelques générations le nombre d’individus possédant cette variation croîtra exponentiellement. Si la variation est défavorable, le nouvel être vivra moins longtemps et se reproduira moins. Par rapport aux autres, le nombre d’individus possédant cette variation sera de plus en plus faible et la variation finira par disparaître. Ainsi chaque espèce va progresser en s’adaptant continuellement à son environnement.

Il peut paraître surprenant qu’un mécanisme apparemment très simple, ne faisant intervenir que des modifications minimes, ait pu conduire peu à peu à l’apparition d’organes aussi complexes que par exemple un œil. On oublie qu’il a fallu pour cela des centaines de millions d’années. Si Darwin connaissait la technique de sélection artificielle, il ignorait les lois de l’hérédité découvertes à la même époque par Grégor Mendel (f). Actuellement, on en connaît non seulement les lois mais aussi le mécanisme qui est celui de la duplication de l’ADN. Ces nouvelles données scientifiques ont amplement confirmé la théorie de Darwin tout en précisant son mécanisme. Rares sont de nos jours les articles en biologie ou en zoologie qui n’y font pas référence ou n’en apportent pas de confirmations nouvelles.

Bien qu’en apparence très simple, le mécanisme proposé par Darwin est en fait très complexe. D’abord les environnements sont très divers ce qui explique la diversité des espèces. Mais aussi les environnements évoluent. Chaque espèce doit continuellement s’adapter à l’évolution de son environnement. Bien plus, cette évolution de l’environnement est en grande partie due à l’influence de l’espèce elle-même (diminution des ressources, pollution, etc…). Cela entraîne la nécessité d’une constante réadaptation. C’est en fait là le moteur même de l’évolution. Enfin, une espèce fait partie de l’environnement d’une autre espèce. L’évolution d’un prédateur est liée à l’évolution de sa proie et vice-versa. C’est pourquoi on parle d’éco-systèmes et de l’évolution globale d’un éco-système.

Vu la complexité du processus, il n’est pas étonnant qu’il ait été souvent mal compris ou mal interprété. Initialement Darwin n’a parlé que de sélection naturelle. C’est le philosophe et sociologue anglais Herbert Spencer (g) qui, enthousiasmé par la théorie de Darwin, a le premier parlé de “survie du plus apte” (en anglais: “survival of the fittest”). Sous l’influence de Spencer, Darwin a repris ensuite cette expression qui, nous allons le voir, prête à confusion.

La difficulté porte sur la signification du mot “apte”. Pour Darwin, la direction de l’évolution est entièrement déterminée par l’environnement. L’individu le plus apte est simplement celui qui est le mieux adapté à son environnement, sans que cela implique une valeur particulière. Spencer voit au contraire l’évolution comme un progrès continu. Puisque la sélection naturelle a produit l’homme, alors elle est intrinsèquement une bonne chose. Il faut donc la favoriser.

Cette interprétation a eu un fort impact dans le monde protestant anglo-saxon qui voit alors la sélection naturelle comme le procédé par lequel Dieu a créé l’homme. Comme il faut accepter la volonté de Dieu, il devient naturel que le “fort” l’emporte sur le “faible”. La découverte de Darwin venait ainsi à l’appui du laissez-faire des théories économiques libérales prônées par Adam Smith (h) et justifiait les inégalités sociales. On sait vers quelles erreurs cette interprétation à conduit, avec le développement au 20ème siècle du racisme et de l’eugénisme.

Quoique plus correcte, l’interprétation que fait Darwin du mot “apte” pose aussi un problème. Si l’individu le plus “apte” est celui qui survit le mieux, alors la “survie du plus apte” devient une tautologie. Il est donc préférable de s’en tenir au rôle propre de la sélection naturelle en mesurant le nombre de descendants. C’est ce que font la plupart des biologistes.

La question se pose alors de savoir sur combien de générations mesurer le nombre de descendants. Cette question est maintenant résolue grâce au développement de la génétique (1). La sélection naturelle n’agirait pas sur les individus mais sur les gènes. Les chromosomes (formés d’ADN) peuvent être décomposés en “sites” occupés par des gènes ayant chacun une fonction particulière. Pour chaque site plusieurs gènes sont possibles parmi un ensemble de gènes appelés allèles (i). La sélection naturelle serait le résultat de la compétition non pas entre les individus mais entre les allèles (i).

Cette interprétation moderne dite “néo-darwinienne” a conduit à la théorie du “gène égoïste” popularisée par Richard Dawkins (2). Le succès de cette théorie est dû au fait qu’elle a permis de comprendre et même de prédire un certain nombre de faits expérimentalement observés dans le monde animal. Selon cette théorie, le véritable reproducteur (ou “réplicateur”) ne serait pas l’individu mais le gène. L’individu ne serait qu’une “machine” construite par nos gènes pour assurer leur reproduction (réplication). Pour paraphraser Dawkins, nous ne sommes que le “véhicule” de nos propres gènes. Pire,“l’intérêt” de ceux-ci ne coïncide pas nécessairement avec le nôtre.

L’interprétation néo-darwinienne a toutefois quelques difficultés à expliquer pourquoi l’évolution a conduit des gènes “égoïstes” à coopérer dans un même chromosome, pourquoi des cellules vivantes se sont mises à coopérer pour former des organismes multicellulaires, et pourquoi ceux-ci coopèrent également entre eux, faisant parfois preuve d’un comportement altruiste. D’une façon générale, la théorie de la sélection naturelle de Darwin a du mal a expliquer le phénomène général d’auto-organisation des systèmes biologiques.

Dans mes prochains articles je montrerai comment ces difficultés peuvent être résolues. Peut-être le lecteur attentif de ce blog aura-t’il déjà deviné la nature de la solution.

(1) D’après ce qui suit, il faut affecter d’un coefficient 1/2 le nombre de nos enfants, d’un coefficient 1/4 le nombre de nos petits enfants, d’un coefficient 1/8 le nombre de nos arrière petits-enfants, et ainsi de suite.

(2) Richard Dawkins, le gène égoïste

(a) http://fr.wikipedia.org/wiki/Nicolas_Copernic

(b) http://fr.wikipedia.org/wiki/Charles_Darwin

(c) http://fr.wikipedia.org/wiki/Théorie_de_l’évolution

(d) http://site.voila.fr/bioafb/evolarti/evolarti.htm

(e) http://fr.wikipedia.org/wiki/Sélection_naturelle

(f) http://fr.wikipedia.org/wiki/Gregor_Mendel

(g) http://fr.wikipedia.org/wiki/Herbert_Spencer

(h) http://fr.wikipedia.org/wiki/Adam_Smith

(i) http://fr.wikipedia.org/wiki/Allèle